domingo, 20 de dezembro de 2020

Gestão de Ativos: Medidas de Desempenho

|

| imagem: techedgegroup.com |

Introdução

Um dos elementos para um Programa de Gestão de Ativos bem-sucedido é identificar os Indicadores Chave de Desempenho (KPI) e como eles serão medidos para que os resultados atendam às necessidades da empresa.

Portanto, é importante alinhá-los com o plano estratégico e as metas de cada Departamento específico. Para ter um conjunto eficiente de indicadores de desempenho, as seguintes condições precisam ser identificadas:

- O que precisa ser encontrado depois que os dados forem coletados e analisados? "Áreas de foco"

- Quais aspectos dos ativos têm um impacto direto nessas áreas? "KPI"

- Como esses aspectos podem ser medidos de forma consistente e eficiente? "Sistema de medição"

Cada empresa tem necessidades diferentes impulsionadas por sua organização interna, condições financeiras e demandas das partes interessadas. Para identificar as áreas de enfoque, o Plano Estratégico anual deve ser revisto.

Para este cenário, um mínimo de três áreas de foco devem ser identificadas com base no Plano Estratégico da empresa:

- Compreender a situação de seu sistema de negócio, para que possa ser aprimorado;

- Obter ferramentas que apoiem as decisões de investimento e alocação de recursos;

- Garantir a responsabilidade e capacidade de resposta às partes interessadas.

KPI

Dentro de uma ampla gama de indicadores-chave de desempenho, é imperativo selecionar os aspectos que impactam diretamente cada uma das áreas acima. Em outras palavras, uma vez que as áreas de foco tenham sido identificadas, as empresas podem direcionar os esforços de coleta de dados de forma mais eficiente.

Não só a qualidade dos dados melhorará, mas também a comunicação e a tomada de decisões serão simplificadas. De um ponto de vista prático, os coletores de dados ficarão mais motivados para fazer seu trabalho se entenderem a razão de seu escopo e puderem ver de forma tangível sua aplicação.

Apoie as decisões de investimento e KPI de alocação de recursos:

Um Programa de Gestão de Ativos não pode focar apenas nos aspectos técnicos dos ativos. Os tomadores de decisão devem ter uma compreensão abrangente de como os ativos impactam a instituição e a comunidade.

Para medir esse impacto e ser capaz de fazer investimentos estratégicos, deve-se monitorar:

- Nível de Retorno do Investimento (ROI):

Neste ponto é necessário atribuir um valor aos ativos e analisar o seu ciclo de vida que envolve custo de manutenção, bem como o impacto monetizado que os ativos têm nos aspectos financeiros da instituição.

A Taxa Interna de Retorno (IRR) é uma das muitas maneiras pelas quais o ROI pode ser medido.

Pode-se pensar na IRR como a taxa de crescimento que se espera que um projeto gere.

- Garantir a responsabilidade e capacidade de resposta às partes interessadas:

O que precisa ser medido nesta área deve estar diretamente relacionado às expectativas e necessidades das partes interessadas. Um Guia de Gerenciamento de Ativos deve descrever as medidas como “desempenhos que são importantes para o cliente, mas podem não ter impacto perceptível na operação da empresa”, em outras palavras, são impressões subjetivas dos clientes/usuários finais do negócio.

Conclusão

A seleção das medidas de desempenho deve ser o resultado de um estudo diligente das necessidades das instituições, bem como das expectativas das partes interessadas; isso irá garantir que os esforços de medição correspondam ao que é importante para eles.

Por outro lado, a análise dos dados coletados, ou KPI, deve prever o nível de desempenho dos ativos com base em sua intenção de design total. As decisões gerenciais tomadas para rebaixar ou manter a intenção do projeto original de um ativo deve ser o resultado da integração e avaliação de todas as áreas de foco para melhor responder ao plano estratégico da empresa.

Quer desenvolver seu gerenciamento de ativos conforme ISO 5500X?

Fale conosco na AQC. Estamos te esperando.

João F Amâncio de Moraes

domingo, 13 de dezembro de 2020

Gerenciamento de um PROJETO DE PESQUISA MULTIDISCIPLINAR: uma análise para adoção do MÉTODO ÁGIL

Princípios e práticas ágeis para PROJETOS DE PESQUISA COLABORATIVA

Originalmente, o termo Ágil foi usado em referência ao desenvolvimento de software. Os princípios básicos da estrutura Ágil foram definidos em 2001 por um grupo de desenvolvedores de software em resposta às fraquezas e rigidez dos métodos de desenvolvimento de software baseados em planos, criticados principalmente por sua falta de capacidade de resposta às mudanças.

Os princípios e práticas centrais da estrutura ágil podem ser resumidos da seguinte forma:

- Ênfase nas pessoas e no trabalho em equipe e nos aspectos sociais do desenvolvimento do projeto;

- Uso de sistemas de visualização compartilhados, com foco em tarefas realizáveis e transparentes;

- Ciclos iterativos de desenvolvimento, com uma equipe auto gerenciada seguindo regras orientadas para a comunicação "leves, mas suficientes".

- Papel fundamental de um Facilitador - ajudando na coordenação e resolução de conflitos e garantindo que os membros da equipe contribuam;

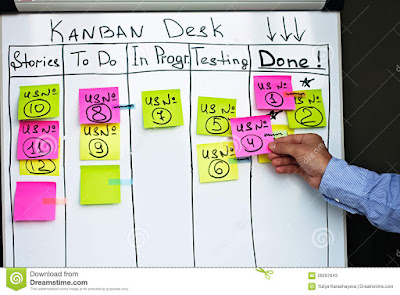

- Uso de um "quadro Kanban" (ou seja, uma ferramenta de visualização de fluxo de trabalho) para refletir o progresso, que é um artefato que permite a documentação e transparência das atividades do projeto.

Estudos sobre o uso de métodos Ágeis relatam resultados predominantemente positivos. Algumas das vantagens aclamadas incluem a influência positiva no desempenho da equipe , a contribuição para os níveis de qualidade e a melhoria dos resultados, como bem como a promoção da confiança e da coesão nas equipes.

A adoção de métodos ágeis se expandiu recentemente para contextos além do desenvolvimento de software. Paralelamente às evidências de que práticas ágeis podem levar a uma “cultura organizacional ágil” além do mundo do desenvolvimento de software.

Para ilustrar algumas aplicações de métodos ágeis fora da industria de software, listo aqui alguns estudos que enfocam a adoção de princípios e práticas Ágeis em projetos de pesquisa. Esses estudos sugerem que os métodos ágeis podem preencher a lacuna entre a indústria e a academia, ou descrever como esses métodos podem ser usados para coordenar equipes distribuídas trabalhando em projetos de pesquisa de grande escala. Outros estudos enfocam o uso de métodos Ágeis para desenvolver protótipos em projetos de pesquisa “action design”, para gerenciar um laboratório de pesquisa e desenvolvimento, para etnografia experimental no local de trabalho, para projetos baseados em evidências para intervenções comportamentais e para desenvolvimento de produtos no setor biofarmacêutico.

Vamos abordar neste artigo, três questões relativos à gestão de projetos de pesquisa colaborativa, que indicam potencial para a aplicação de métodos ágeis:

(1) Por um lado, os projetos de pesquisa operam sob considerável incerteza e requerem liberdade e flexibilidade para gerar resultados inovadores. Por outro lado, a incerteza precisa de um gerenciamento rígido para evitar o fracasso e a criatividade precisa de estruturas firmes para ser transformada em resultados de projeto amplamente utilizáveis.

(2) Por um lado, a pesquisa colaborativa promove a integração das percepções, idéias e visões da pesquisa que são necessárias para resolver problemas de forma abrangente. Por outro lado, a heterogeneidade resultante de parceiros leva a problemas com respeito à gestão intercultural, interorganizacional e interdisciplinar.

(3) Por um lado, o gerente é atribuído apenas autoridade limitada devido à autonomia dos sócios e estruturas de governança. Por outro lado, os resultados mostram que determinadas tarefas, como a gestão da visão do projeto e a integração dos resultados, requerem o empenho e envolvimento de todas as partes do projeto.

Essas três questões acima serão o foco de análise deste artigo. A primeira e o segunda questões são as bases das seguintes questões da análise:

- Até que ponto os princípios e práticas ágeis podem oferecer mecanismos de coordenação envolventes, transparentes e fáceis de adotar em projetos de pesquisa colaborativa?

- Como os métodos ágeis podem contribuir para a comunicação entre os participantes de projetos de pesquisa colaborativa?

- A terceira questão dá origem às seguintes questões da análise:

- Os princípios e práticas ágeis podem ajudar a integrar diferentes perspectivas disciplinares para trabalhar em direção a resultados de pesquisa de qualidade?

- Os princípios e práticas ágeis podem ajudar a facilitar o comprometimento e envolvimento dos participantes em projetos de pesquisa colaborativa?

Quatro práticas Ágil que podem suportar as questões acima:

Lançamentos regulares: Essa é uma prática ágil para garantir o desenvolvimento incremental dos resultados. Uma prática mais genérica toma a forma de reuniões de planejamento regulares realizadas a cada 2 semanas, nas quais todos os membros da equipe que trabalham em vários aspectos do projeto participam para estabelecer e discutir os objetivos das entregas. Deve haver acordos periódicos sobre tarefas e subtarefas para cada membro da equipe.

Facilitação ágil: Para se ter uma equipe multifuncional atuando iterativamente em direção aos objetivos definidos, o processo deve ser coordenado por um pesquisador que cumpra a função de Facilitador ou “Scrum Master”, mantendo rotinas de comunicação. O pesquisador principal, como “product owner”, avalia a qualidade geral e o alinhamento com o projeto mais amplo, na existência deste.

Stand-up semanal: Esta prática refere-se a uma reunião presencial regular, mas informal, onde os participantes atualizam uns aos outros sobre o andamento de suas atividades de projeto. Conversa virtual semanal pode substituir os encontros presenciais. Isso pode ser conseguido através de aplicativos da web tais como MSTeams, Zoom e Slack, a título de exemplo. Cada membro deve apresentar relatórios semanais para a equipe sobre as realizações desde o último stand-up semanal, tarefas planejadas antes do próximo e desafios que provavelmente deverão ser enfrentados nesse ínterim.

Quadro Kanban Digital: Isso se refere à prática ágil de usar uma ferramenta de visualização de fluxo de trabalho para refletir o status das tarefas do projeto. Os itens de tarefas, com suas descrições em notas adesivas virtuais, são refletidos em um quadro compartilhado usando o software Trello ou Jira, a título de exemplo, para que os fluxos de trabalho possam estar visíveis a todos os membros da equipe.

Usando métodos ágeis para equilibrar flexibilidade e coordenação

O papel do Facilitador é fundamental na adoção pela equipe de pesquisa dos princípios e práticas ágeis.

A percepção de participantes de trabalhos com métodos Ágil frequentemente se mostram altamente positiva em relação à forma como o processo se desenvolve, desde a distribuição das tarefas e coordenação do grupo, até a possibilidade de os indivíduos influenciarem o desenho da pesquisa.

Apesar de diferentes níveis de engajamento, membros de equipe Ágil se adaptam à lógica da interface do quadro Kanban ao utilizá-lo, focando em um fluxo contínuo de tarefas, envolvendo iterações quando necessário.

Deve-se buscar pela prática ágil de "sprints de desenvolvimento fixos", ou seja, um segmento de tempo, geralmente entre 2-4 semanas, durante o qual as equipes trabalham para atingir os objetivos especificados para a eventual liberação da entrega final.

Mas em projetos fora da industria de software, muito das vezes isto se apresenta como um forte desafio, então, em vez disso, a equipe pode optar por usar um chat convocado através de software, e.g. MSTeams, Zoom, Slack para se comunicar quando necessário em relação às tarefas acordadas, bem como a adoção de aplicativos já mencionado (e.g. Trello, Jira) para discussões além da coordenação ágil. Paralelamente, pode se fazer uso do software Google Docs, a título de exemplo, para compartilhar documentos online para escrita colaborativa e desenvolvimento modular de textos antes da publicação.

Alcançando a Integração em Equipes Heterogêneas

A terceira questão reflete a necessidade de integração de percepções, ideias e visões necessárias para a resolução abrangente de problemas em equipes colaborativas. Os desafios podem surgir da diversidade intercultural, interorganizacional e interdisciplinar entre os membros da equipe.

Para contornar situações de potenciais problemas relativo a uma ou mais situações de diversidades comentadas, deve-se fomentar que em paralelo à execução de tarefas específicas, os pesquisadores também devem participar das atualizações digitais do stand-up e também trocarem outros tipos de mensagens de coordenação (principalmente lembretes de reuniões, links para vários documentos em andamento ou feedback específico sobre o trabalho individual). Este volume adicional de atividade de comunicação durante a adoção dos métodos ágeis, em relação às tarefas atribuídas, tende a se correlacionar com os participantes mais ativos e com mais tempo dedicado ao projeto.

Há amplo consenso sobre a contribuição dos métodos Ágeis para melhorar a interação da equipe para uma melhor comunicação e visualização do trabalho dos outros. As reuniões presenciais de acordo com suas respectivas frequências previamente definidas(onde a avaliação e distribuição de tarefas são revistas, e novas tarefas devem ser subsequentemente atribuídas) às vezes podem apresentar alguns viéis decorrentes da influência de um ou mais pesquisadores mais experientes dentro do time. Pode também ocorrer falta de acordo sobre a distribuição de tarefas, o que pode ser mitigado através de um uso mais apurado do quadro Kanban mencionado anteriormente.

De qualquer maneira, caso se apresente as situações comentadas, cabe ao Facilitador (ou Scrum Master, por exemplo), e o pesquisador principal (Product Owner) trazer o time de volta às práticas e métodos Ágil. A integração das equipes é um fator primordial para o sucesso de projetos Ágil.

Então, sua empresa já se vê às voltas com a aplicação de métodos Ágil de gestão de projetos (de produto e/ou de melhoria de processos) em sua estratégia de negócios? Caso o método Ágil ainda não está incluso em seus planos, sugiro que considere o fato de incluí-lo.

Nós, da AQC, podemos suportar sua empresa nesta empreitada. Fale conosco.

Amâncio

quinta-feira, 10 de dezembro de 2020

Melhore suas retrospectivas ágeis aprendendo com a ciência!

Quão bem as retrospectivas do Agile estão atendendo você?por Jutta Eckstein , John Buck

Presumimos que você siga a agenda de retrospectivas do Agile começando com a definição do cenário e, em seguida, coletando dados e, em seguida, gerando percepções antes de decidir sobre as ações e fechar as retrospectivas. Além disso, esperamos que em sua próxima retrospectiva você reveja suas decisões anteriores para avaliar se conseguiu implementar essas ações e se elas fizeram alguma diferença.

No entanto, como você sabe que foram essas ações que fizeram a diferença? Além disso, se eles fizeram a diferença, que tipo de diferença eles fizeram?

O que você precisa para ser capaz de responder a essas perguntas é uma abordagem mais científica para suas retrospectivas.

Isso significa que, para cada ação (ou experimento) em consideração, você precisa explorar sua hipótese - o que você presume que acontecerá ao realizar essa ação? Além disso, como saber mais tarde se essa hipótese foi validada ou não?

É tudo sobre o processo lógico que você segue. Se você olhar para todos os fatos e decidir agir de acordo com o que parece ser a melhor solução, você está sendo um bom detetive. Você está usando o que é chamado de lógica abdutiva . Isso pode levar a melhorias efetivas, mas também pode levar a muitos problemas: o mesmo problema ocorrendo novamente ou ressurgindo de uma forma diferente - em qualquer caso, não está resolvido. Outra abordagem é se tornar um bom cientista - usar a lógica indutiva .

A lógica indutiva significa que quando uma equipe durante uma retrospectiva pensa em uma ação para resolver um problema, ela faz uma pausa para perguntar: "Qual é a nossa hipótese?" Uma hipótese diz: “Dado este pano de fundo e com base nesta teoria geral ou abordagem aceita, se fizermos x, y, z, esperamos ver o seguinte resultado, que mediremos pelo seguinte. Além disso, prevemos que as medidas serão l, m, n. Essa hipótese forma a base de um experimento.

A medição é crítica.

Você precisa primeiro saber quais são suas medições antes de começar seu experimento para que você tenha algo para comparar com seus resultados posteriores! Se você não tiver certeza sobre “ como medir qualquer coisa”, recomendamos enfaticamente o livro com esse título de Douglas W. Hubbard. As medições podem ser objetivas ou subjetivas. Melhor ainda, você pode procurar maneiras de ter um "grupo de controle". Por exemplo, algumas pessoas em sua equipe tentam um novo método e outro membro da equipe continua fazendo do jeito antigo. Ou você pode comparar as equipes.

Somente com uma hipótese e um plano experimental com medidas adequadas você será capaz de dizer se precisará de uma ação diferente ou se terá que repensar sua hipótese. Em nosso livro sobre Agilidade em toda a empresa , chamamos esse processo de “sondagem” e isso o ajuda não apenas a melhorar continuamente, mas também a inovar de forma sustentável.

Há mais um aspecto nas sondagens: a possibilidade de publicação. “O que acontece em uma retrospectiva permanece na retrospectiva” é um mantra familiar e deve, é claro, ser respeitado. No entanto, se você descobrir um processo ou procedimento que parece fazer uma grande diferença, você pode desejar, com o consentimento de todos, contar aos outros sobre suas descobertas. A publicação, de uma forma que respeite a privacidade da retrospectiva, pode ser muito importante porque o ato de publicar seus resultados pede a outras pessoas que tentem replicar o que você acha que aprendeu. Você aprenderá com as experiências deles e confirmará que o que você descobriu é realmente uma nova descoberta.

Portanto, considere o desenvolvimento de sondas em suas retrospectivas, tornando-se mais como cientistas e menos como detetives.

segunda-feira, 16 de novembro de 2020

terça-feira, 27 de outubro de 2020

SEBRAE LANÇA CATALISA ICT

O Sebrae apresentou na último dia 16/10 o Catalisa ICT, projeto que vai estimular o ingresso de pesquisadores acadêmicos no universo do empreendedorismo. A expectativa é que sejam selecionadas pelo menos mil pesquisas brasileiras com potencial de inovação.

O Catalisa ICT é uma iniciativa de alcance nacional, que irá contemplar pesquisadores das 27 unidades da federação. A jornada de aceleração dos pesquisadores para o empreendedorismo terá quatro etapas: mobilização, capacitação, desenvolvimento e teste e tração.

quinta-feira, 22 de outubro de 2020

Normas ISO 5500x - Gestão de ativos físicos [críticos]

O gerenciamento de ativos é de fundamental importância, pois está relacionado à forma de administrar os riscos com eficiência, tomar decisões de investimentos capazes de acarretar o máximo rendimento dos ativos, reduzir perdas e garantir confiabilidade e qualidade dentro de um mercado cada vez mais exigente.

Atualmente constata-se que poucas empresas possuem uma estratégia clara e um plano oficial de substituição, renovação ou reforço de ativos capaz de propiciar a qualidade e confiabilidade exigida e ao mesmo tempo gerar a rentabilidade e lucratividade esperada pelos acionistas. Este panorama deve-se em parte às dificuldades de acessar e implantar as boas práticas de gestão de ativos.

Em empresas que já praticam a gestão de ativos nota-se maior domínio do gerenciamento de riscos em cada nível (estratégico, tático e operacional) e uma capacidade de demonstrar sistemas estruturados, de alta confiabilidade e qualidade que podem superar o desempenho exigido pelo mercado.

Esta nova abordagem trouxe uma vantagem competitiva para as empresas através de um melhor desempenho técnico e financeiro, da visão estratégica do negócio, do melhor equilíbrio entre retorno e riscos e do aumento da confiabilidade do sistema como todo. O sistema de gestão permite indicar quais ações nos ativos agregam maior valor econômico para as empresas, melhoram a qualidade do serviço e aumentam a confiabilidade de diversos sistema, além de agregar valor para todos os segmentos, pois para os clientes é a forma de obter produtos e serviços de qualidade por um preço justo, em outras palavras, é a garantia de que a empresa está investindo corretamente e sem desperdícios na melhoria de seu desempenho e para os acionistas é a certeza que seus ativos são operados e mantidos de forma consistente com o objetivo de gerar a mais alta taxa de retorno de seus investimentos.

Ao longo dos anos, as organizações preocupadas com sua gestão, operação e manutenção de infraestruturas têm procurado reduzir as despesas de capital (CAPEX) e os custos operacionais (OPEX) associados à sua atividade, garantindo um adequado nível de produto e serviços ao longo do seu ciclo de vida e permitindo às organizações atingir os seus objetivos estratégicos.

Para dar resposta a estas necessidades, a International Organization for Standardization (ISO) desenvolveu em 2014 um padrão internacional, a norma ISO 55001:2014 - Gestão de Ativos - Sistemas de gestão - Requisitos, que especifica os requisitos para que as organizações estabeleçam, implementem, mantenham e melhorem seu sistema de gestão de ativos.

SISTEMAS DE GESTÃO DE ATIVOS - ISO 5500x

Muitas organizações dependem de modo crítico dos seus ativos. Um ativo “é um bem, uma coisa ou uma entidade, que tem um valor potencial ou real para uma organização“. Para que a atividade seja eficiente e sustentável, torna-se necessário assegurar que esses ativos sejam geridos de modo sistemático e racional nas organizações.

Deste modo, enumeram-se algumas motivações para que a gestão de ativos seja cada vez mais prioritária dentro das organizações, tais como: sistemas de ativos envelhecidos; incremento da exigência dos requisitos de qualidade, segurança e ambiente; aumento do risco; globalização e aumento da competitividade; instabilidade dos mercados; maior pressão para fomentar a rentabilidade e retorno dos ativos; sistemas de incentivos da gestão de topo; princípios de contabilidade inflexíveis; comunicação inadequada ou inexistente entre os diferentes níveis das organizações e, por fim, mas não menos importante, a necessidade de integração e modernização de sistemas de ativos.

Em 2014, a International Organization for Standardization (ISO), publicou a série de normas ISO 5500x para a gestão de ativos, nomeadamente as normas ISO 55000:2014, ISO 55001:2014 e ISO 55002:2014. A sua publicação associada à formação de profissionais na área, tem servido como estímulo no processo de reconhecimento da importância da gestão de ativos enquanto atividade chave para as organizações.

Na ISO 55000 é apresentada uma visão geral da gestão de ativos e dos sistemas de gestão para a gestão de ativos, designado como sistema de gestão de ativos. É definida gestão de ativos como a atividade coordenada de uma organização para identificar e produzir valor a partir dos ativos. É especificado também o contexto para as normas ISO 55001 e ISO 55002.

Na norma ISO 55001 são especificados os requisitos para um sistema de gestão de ativos e na ISO 55002, são especificados em pormenor os requisitos técnicos específicos de setores, de ativos ou de atividades e fornece orientações sobre como a ISO 55001 deverá ser interpretada.

Sua empresa já conhece essa família de normas ISO 5500x? Lendo acima, você vê benefícios em entender mais profundamente e aplicar a ISO 55001 dentro da estratégia de negócios de sua empresa?

Se há interesse, nós da Amancio Quality Consulting podemos suportá-lo no desenvolvimento dos requisitos e procedimentos em sua organização.

Entre em contato; AQC - Otimizando processos - (19) 998953115 - bit.ly/AQCwix.

quinta-feira, 15 de outubro de 2020

Mineração de processos: Visão geral e oportunidades

|

| imagem: Medium.com |

Na última década, a mineração de processos (Process Mining) surgiu como um novo campo de pesquisa que se concentra na análise de processos usando dados de eventos.

As técnicas clássicas de mineração de dados, como classificação, agrupamento, regressão, aprendizagem de regras de associação e mineração de sequência / episódio, não se concentram em modelos de processos de negócios e geralmente são usadas apenas para analisar uma etapa específica no processo geral. A mineração de processos concentra-se em processos ponta a ponta e é possível devido à crescente disponibilidade de dados de eventos e novas técnicas de descoberta de processo e verificação de conformidade.

Os modelos de processo são usados para análise (por exemplo, simulação e verificação) e execução por sistemas como o Business Process Management (BPM). Anteriormente, os modelos de processo eram normalmente feitos à mão, sem usar dados de eventos. No entanto, as atividades executadas por pessoas, máquinas e software deixam rastros nos chamados registros de eventos. As técnicas de mineração de processos usam esses logs para descobrir, analisar e melhorar os processos de negócios.

Recentemente, a Força-Tarefa de Process Mining lançou o Manifesto de Process Mining. Este manifesto é apoiado por 53 organizações e 77 especialistas em mineração de processos contribuíram para ele.

O envolvimento ativo de usuários finais, fornecedores de ferramentas, consultores, analistas e pesquisadores ilustra a crescente importância da mineração de processos como uma ponte entre a mineração de dados e a modelagem de processos de negócios. A relevância prática do Process Mining e os desafios científicos interessantes tornam o Process Mining um dos tópicos “quentes” em Business Process Management (BPM). Vamos aqui comentar a mineração de processos como um novo campo de pesquisa.

A mineração de processos tem como objetivo descobrir, monitorar e melhorar os processos reais, extraindo conhecimento de registros de eventos disponíveis nos sistemas de informação atuais.

Na última década, houve um crescimento espetacular dos dados de eventos e as técnicas de mineração de processos amadureceram significativamente. Como resultado, as tendências de gerenciamento relacionadas à melhoria e conformidade de processos agora podem se beneficiar da mineração de processos.

O ponto de partida para o Process Mining é um log de eventos.

Cada evento em tal registro se refere a uma atividade (ou seja, uma etapa bem definida em algum processo) e está relacionado a um caso particular (ou seja, uma instância de processo). Os eventos pertencentes a um caso são ordenados e podem ser vistos como uma “execução” do processo. Os logs de eventos podem armazenar informações adicionais sobre os eventos. Na verdade, sempre que possível, as técnicas de mineração de processos usam informações extras, como o recurso (ou seja, pessoa ou dispositivo) que executa ou inicia a atividade, o carimbo de data / hora do evento ou elementos de dados registrados com o evento (por exemplo, o tamanho de um pedido).

Os logs de eventos podem ser usados para conduzir três tipos de mineração de processo.

O primeiro tipo de mineração de processo é a descoberta. Uma técnica de descoberta pega um log de eventos e produz um modelo sem usar nenhuma informação a priori. A descoberta de processos é a técnica de mineração de processos mais proeminente. Para muitas organizações, é surpreendente ver que as técnicas existentes são realmente capazes de descobrir processos reais apenas com base em exemplos de comportamento armazenados em logs de eventos.

O segundo tipo de Process Mining é a conformidade. Aqui, um modelo de processo existente é comparado com um log de eventos do mesmo processo. A verificação de conformidade pode ser usada para verificar se a realidade, conforme registrada no registro, está de acordo com o modelo e vice-versa.

O terceiro tipo de mineração de processo é o aprimoramento. Aqui, a ideia é estender ou melhorar um modelo de processo existente, usando, assim, informações sobre o processo real registrado em algum log de eventos. Enquanto a verificação de conformidade mede o alinhamento entre o modelo e a realidade, este terceiro tipo de Process Mining visa alterar ou estender o modelo a priori. Por exemplo, usando carimbos de data / hora no log de eventos, pode-se estender o modelo para mostrar gargalos, níveis de serviço e tempos de processamento.

Ao contrário das técnicas tradicionais de Business Process Management (BPM) que usam modelos feitos à mão, a mineração de processos é baseada em fatos. Com base no comportamento observado registrado em logs de eventos, técnicas inteligentes são usadas para extrair conhecimento.

Portanto, pode-se afirmar que a mineração de processos permite um BPM baseado em evidências. Ao contrário das abordagens de análise existentes, a mineração de processos é centrada em processos (e não em dados), verdadeiramente inteligente (aprendendo com dados históricos) e baseada em fatos (baseada em dados de eventos em vez de opiniões).

A mineração de processos está relacionada à mineração de dados. Considerando que as técnicas clássicas de mineração de dados são principalmente centradas em dados, a mineração de processos é centrada no processo.

As principais técnicas de modelagem de processos de negócios usam notações como Business Process Modeling Notation (BPMN), diagramas de atividades UML, Event-driven Process Chains (EPC) e vários tipos de redes de Petri.

Em próximos artigos, vamos comentar um pouco mais nos detalhes, algumas das principais técnicas de modelagem na mineração de processos.

sexta-feira, 9 de outubro de 2020

Análise para integração do Design for Six Sigma (DFSS)

Design for Six Sigma (DFSS) pode ser definido como uma metodologia de desenvolvimento para novos produtos, serviços e/ou processos - soluções de proteção proativa para cumprir as condições seis sigma.

Existem diferentes opções de implementação do DFSS. Ao contrário do Six Sigma, que é comumente conduzido por meio de projetos Definir-Medir-Analisar-Melhorar-Controle (DMAIC), no DFSS surgiram vários processos graduais, todos no estilo do procedimento DMAIC.

A falta de clareza com relação ao DFSS e o foco da maioria das descrições nas ferramentas oferecem duas explicações possíveis para o fato de que muitas empresas ainda hoje estão lutando para implementar o DFSS. As empresas simplesmente não sabem onde e como começar e como continuar seus esforços de DFSS de maneira estruturada.

Ao examinar mais de perto as motivações mais operacionais para implementar e trabalhar com DFSS, chega-se a algumas razões mais concretas as quais podem ser citadas na forma de objetivos corporativos, que são brevemente descritos a seguir.

- Evitar modos de falha

O programa Seis Sigma prova seu valor principalmente eliminando falhas ou melhorando processos, de preferência nas etapas de produção. Nota-se que com a implementação do DFSS, muitos modos de falha podem ser evitados. Em outras palavras, o desempenho aprimorado de desenvolvimento de produto (DFSS) evitará a ocorrência de muitos modos de falha em potencial durante a fabricação e testes.

- Aumento da eficácia da engenharia

Muitas ferramentas da metodologia DFSS, como o Quality Function Deployment (QFD) ou o modelo Kano, contribuem para carregar o setor de Pesquisa e Desenvolvimento de Produto (PDP) no front-end com o objetivo de alcançar a estabilidade do projeto o mais cedo possível.

Ao atingir a estabilidade do projeto mais cedo, acredita-se que ocorra um aumento da eficácia da engenharia - tudo de acordo com o lema “mudanças iniciais baratas devem ser preferidas às tardias mais caras”.

- Reforço do processo de desenvolvimento

O Design for Six Sigma visa melhorar o desempenho do PDP, por exemplo, direcionando o foco dos esforços para os aspectos mais essenciais de forma sistemática desde o início dos projetos de desenvolvimento.

- Estímulos para a inovação e criatividade

O objetivo é estimular a inovação e a criatividade, utilizando os recursos do DFSS, como ferramentas de voz do cliente e pensamento funcional em combinação com ferramentas de criatividade, como TRIZ. A compreensão funcional das necessidades do cliente permite a criatividade e abre as portas para soluções mais inovadoras. O design é gerado a partir de requisitos funcionais com uma mente aberta e não predeterminada no início do desenvolvimento: as necessidades modelam o design - o design não modela as necessidades.

- Aumento da satisfação do cliente

Uma intenção fundamental da DFSS é aumentar a satisfação do cliente. Por um lado, isso é alcançado por um foco mais forte no cliente em si e nas necessidades do cliente e, por outro lado, focando na robustez e, assim, minimizando a variação do desempenho do produto em torno dos valores de desempenho alvo.

Desenvolvendo para Six Sigma - um mapa para o processo

Um aspecto importante, senão o mais importante para começar, pode ser o de esclarecer as fontes de inspiração e informações nas quais o processo se baseará. Em primeiro lugar, a experiência e o conhecimento adquiridos ao longo dos anos dentro da empresa - sua cultura organizacional - desempenham um papel vital e serão inevitavelmente refletidos no resultado final. Em segundo lugar, a literatura convencional de desenvolvimento de produtos deve ser consultada. Em terceiro lugar, livros de texto DFSS devem ser lidos. Em quarto lugar, o benchmarking de empresas líderes devem ser levado em consideração e, por fim, um seminário executivo direcionando a atenção para os princípios do DFSS.

Todas essas fontes levam a um novo PDP da empresa que deve consistir em quatro fases principais:

- Viabilidade técnica consiste de: i) escopo; ii) especificação e requisitos e iii) geração e seleção de conceito.

- Projeto e verificação: i) incorporação do projeto; ii) detalhe do projeto e iii) verificação final

- Validação

- Entrega

- Entrega: Objetivo principal e limitações para o projeto / tarefa de desenvolvimento, incluindo a identificação do cliente interno.

- Checklist: Assegurar o envolvimento de todas as partes necessárias (stakeholders)da organização. Verifique se o inquérito está completo

- Entrega: Necessidades do cliente classificadas e expressas em requisitos funcionais mensuráveis, CTQs, requisitos não funcionais (por exemplo, ambientais, regulamentares, de segurança, custo, etc.), critérios de verificação e validação.

- Ferramentas: Benchmarking, QFD (House of Quality), modelo Kano, Scorecard, métodos de coleta de VOC

- Checklist: Reunir VOC (externo e interno), classificar as necessidades do cliente e traduzir em requisitos funcionais mensuráveis com valores-alvo

- Entregas: Descrição dos conceitos mais promissores, plano de verificação e validação

- Ferramentas: Matriz de Pugh / Hibridização, Avaliação comparativa, Inovação & ferramentas de criatividade (por exemplo TRIZ, seis chapéus)

- Checklist: Definir critérios de seleção de conceito (por exemplo, robustez, confiabilidade, custo), Gerar conceitos em equipes multifuncionais, Avaliar e classificr os conceitos de acordo aos critérios de seleção definidos, incluindo robustez.

- Entregas: Documentação do produto, (por exemplo, desenho, descrição funcional, avaliação do modo de falha ), protótipos (incl. protótipos virtuais), identificação do fornecedor (interno e / ou externo), plano de confiabilidade e robustez, verificação atualizada e plano de validação

- Ferramentas: Simulação, prototipagem, DoE, D-FMEA, VMEA, funções de transferência, mapeamento do processo funcional , FAST (Functional Analysis System Technique), Diagrama P, QFD (Casas de Qualidade) e Design for X.

- Checklist: Obter compreensão funcional de conceito (s), identificar modos e efeitos de falha, tradução de requisitos funcionais em parâmetros de design, mapear fatores de ruído (por exemplo, externo, interno e unidade a unidade). Fazer uma verificação preliminar do projeto: cálculos (funções de transferência), modelagem e simulação, testes físicos, desenvolver plano de robustez e confiabilidade, atualizar e refinar o plano de verificação e validação (influência do fator de ruído, parâmetros de projeto)

- Entregas: Documentação do produto, regras de projeto propostas, e os princípios de medição,

- Ferramentas: funções de transferência, função de perda para projeto de tolerância, D-FMEA, DoE, métodos de Taguchi, projeto de parâmetros, análise de sensibilidade, ANOVA, projeto para X

- Checklist: Executar a verificação preliminar do projeto: cálculos (funções de transferência), modelagem e simulação, testes físicos, contabilização de robustez e confiabilidade, mapeamento de fator de ruído de atualização, realização de caracterização do produto (modelo matemático para otimização), projeto de otimização (média e variação), projeto de tolerância de desempenho.

- Entregas: Documentação do produto, regras de design liberado, produto liberado (pronto para validação)

- Ferramentas: Teste, modelagem e simulação, teste HALT / HAST

- Checklist: Realizar teste de verificação, avaliação de robustez e confiabilidade

- Entregas: Documentação do produto, design comprovado no ambiente pretendido

- Ferramentas: Testes de campo, testes, modelagem e simulação, testes HALT / HAST

- Checklist: Realizar testes de validação, avaliação de robustez e confiabilidade

- Entregas: Documentação de desenvolvimento de produto, suporte de lançamento

- Checklist: Documentar as lições aprendidas com o projeto, incluindo lições de robustez e confiabilidade

quarta-feira, 7 de outubro de 2020

Qualidade preditiva: em direção a uma nova compreensão de garantia de qualidade usando ferramentas de aprendizado de máquina

Falhas de produtos são temidas pelos fabricantes pelos custos associados e danos resultantes à sua imagem pública. Embora a maioria dos defeitos possa ser rastreada até as decisões tomadas no início do processo de design, eles geralmente são descobertos muito tarde, durante as verificações de qualidade (gerando custos da má qualidade) ou, na pior das hipóteses, descobertos durante o uso pelo cliente.

Um sistema baseado em aprendizado de máquina que automaticamente retroalimenta insights sobre as taxas de falha dos processos de garantia de qualidade e retorno para o processo de design, sem a necessidade de qualquer análise manual de dados, ajuda a garantir a qualidade do produto de forma preventiva.

A norma ISO9000 para gestão da qualidade define a garantia da qualidade como a “parte da gestão da qualidade focada em fornecer confiança de que os requisitos de qualidade serão atendidos”. O tempo futuro nesta definição indica que a garantia de qualidade deve ser proativa: os efeitos adversos das falhas de qualidade devem ser evitados antes de se tornarem relevantes no uso real de um produto, por exemplo, por definição rígida de como um produto deve ser montado. Um termo intimamente relacionado é o da qualidade preditiva, que se refere a métodos que, com base em dados, identificam padrões estatísticos para prever desenvolvimentos futuros relativos à qualidade de um produto.

A Garantia da Qualidade deve ser preditiva (deve tirar conclusões dos dados) e preventiva.

A Garantia da Qualidade não deve simplesmente evitar que produtos defeituosos passem para os clientes, mas deve também focar na geração de resíduos internos. Idealmente, as próprias falhas devem ser evitadas erradicando suas causas, que muitas vezes são frutos das decisões de projeto desfavoráveis. Uma ferramenta para conseguir uma performance favorável é a previsão baseada em dados, mas esta precisa acontecer antes mesmo de um produto ser produzido, não depois. Além disso, esse processo não deve depender de análises manuais caras, demoradas e sujeitas a erros, mas deve ser ativado por aprendizado de máquina automatizado.

Arquitetura para garantia de qualidade preventiva

Vamos fazer uma breve conjectura acerca de uma arquitetura geral e da funcionalidade de um sistema de Garantia de Qualidade Preventiva de um ponto de vista teórico e independente.

Num conceito geral, o sistema deve consistir de um componente de análise autônoma e outro de assistência em tempo real. O componente de assistência fornece feedback em tempo real para designers de produto ou gerentes sobre suas decisões, enquanto o componente de análise gera as estruturas de dados necessárias para fornecer as funções de assistência.

A entrada consiste em fontes heterogêneas de informações sobre produtos e suas taxas de falha (implicitamente associadas), por exemplo, dados de software de planejamento de recursos empresariais (ERP), documentos técnicos detalhando projetos de produtos e/ou registros de verificação de qualidade.

Esses dados estruturados podem ser enriquecidos por dados não estruturados, como fotografias dos produtos defeituosos ou descrições textuais. Em geral, o pré-requisito é a informação sobre análise em produtos existentes, suas características e os respectivos casos defeituosos.

• A saída do sistema, fornecida pelo componente de assistência, consiste em duas funções: Primeiro, o sistema julga o estado atual de um produto e notifica o responsável se for detectado um risco aumentado de defeitos, mostrando possíveis defeitos com sua probabilidade e amostras de produtos similares existentes exibindo os defeitos para servir como uma justificativa e aumentar a aceitação do sistema.

• Em segundo lugar, o sistema pode ser consultado para alternativas que são tão semelhantes quanto possível a uma configuração definida, mas têm uma taxa de falha estimada menor.

Numa condição de Análise de Dados Automatizada, o componente de análise de dados aprende um mapeamento de produtos com as taxas de defeito associadas com base nas informações coletadas de produtos existentes. Em particular, esse mapeamento também pode ser aplicado a produtos totalmente novos e inéditos.

Assistência em tempo real deve responder a dois tipos de consultas, uma sobre os riscos envolvidos no design de um determinado produto e outra para recuperar alternativas com maior qualidade prevista.

Há também de se considerar a escolha de um método de classificação dentre diversos disponíveis. Alguns dos diferentes algoritmos de classificação para a implementação de meta classificadores estão listados aqui: regressão logística, Bayes ingênuo, florestas aleatórias, redes neurais de estilo perceptron multicamadas (MLPs) e AdaBoost com base em árvores de decisão. Esta lista serve aqui para ilustrar os modelos já disponíveis no mercado mas não é objeto deste artigo discutir os benefícios, os desafios e conceitos básicos de cada uma delas.

Assim, a ideia da Garantia Preventiva da Qualidade, um sistema que orienta os responsáveis pelo desenvolvimento de novos produtos nas suas decisões de forma a otimizar a qualidade do produto, traz em si, como principal característica, um grau de automação intrínseco, ou seja: um usuário não precisa ser um especialista em análise de dados, mas recebe automaticamente o conhecimento e a assistência de que precisa em cada momento.

Para tanto, aspectos como a análise de dados não estruturados, a realização de funções de assistência e uma integração com outros softwares deverão ser considerados dentro do pacote de implementação. Combinar várias fontes de dados além dos sistemas ERP, como arquivos de design de produto ou verificações de qualidade, ajuda a aumentar a precisão das previsões e a aplicabilidade em mais etapas do processo de desenvolvimento.

Então, sua empresa já vem discutindo uma estratégia de médio e longo prazo no tocante ao desenvolvimento e implementação gradual de machining learning em seus processos chaves? Se ainda não se iniciou discussão neste sentido, eu me atrevo a dizer que sua empresa já carrega um grau de atraso comparado à alguns de seus competidores líderes de sua indústria. Considere!

João F Amancio de Moraes.

AQC – Otimizando Processos.